Как новичку создать и распознать дипфейк?

Технологии становятся все лучше в моделировании реальности. Созданные с помощью искусственного интеллекта (ИИ) медиаданные попали в заголовки известных изданий — особенно видео, где кто-то говорит или совершает что-то, чего на самом деле не делал.

Группа старшеклассников из Нью-Йорка сгенерировала ролики, на которых директор средней школы делает расистские высказывания и угрожает ученикам. В Венесуэле с помощью ИИ создали видео для распространения политической пропаганды. Стримера Twitch поймали на просмотре сайта с фейковым порно-контентом с женщинами-геймерами.

Во всех трех случаях сгенерированные с помощью ИИ видео созданы с целью убедить людей в том, что кто-то сделал то, чего на самом деле никогда не совершал.

Такой контент называется дипфейком.

Что такое дипфейк?

Дипфейк — это технология синтезирования медиаданных, на которых лицо человека на существующих фото или видео заменяется лицом другого человека. При создании подделок используются методы искусственного интеллекта, машинного обучения и нейронных сетей.

С помощью таких систем можно синтезировать убедительные фейковые видео, фотографии и «голосовые клоны».

Примечание: название технологии происходит от сочетания английских терминов deep learning (глубокое обучение) и fake (подделка).

Слово «дипфейк» возникло в конце 2017 года. Его применил пользователь Reddit под ником deepfakes. Он поделился ИИ-видео, где «прикрепил» лица знаменитостей на тела актрис в порнографических роликах.

В то время также стал популярен контент с поддельным Николасом Кейджем в различных фильмах, где он не снимался.

Однако deepfakes нельзя считать изобретателем технологии. Она является результатом работы множества исследователей и энтузиастов в течение нескольких десятилетий.

Чем дипфейки отличаются от других видов манипулируемых медиа?

Дипфейки — это не просто фальшивый или вводящий в заблуждение контент.

Изображение Папы Римского Франциска в пуховике или якобы фото ареста бывшего президента США Дональда Трампа, распространяемые незадолго до предъявления ему обвинения, созданы с помощью ИИ. Однако это не дипфейки.

Подобный контент в сочетании с вводящей в заблуждение информацией обычно называют «поверхностными фейками» (shallowfakes).

Дипфейк отличает элемент человеческого вклада. Только в конце синтеза пользователь решает, подходит ли ему результат. Он также может адаптировать обучающие данные, однако более никак не влияет на алгоритм.

Как создают дипфейки?

Существует несколько методов создания дипфейков. Наиболее распространенный основан на применении глубоких нейросетей, использующих технику подмены лиц.

Пользователю требуется видео, которое станет базой для дипфейка, и ролики с человеком, чье лицо необходимо вставить.

Медиаданные не обязательно должны пересекаться друг с другом. Основой может стать, например, отрывок из голливудского фильма, а другие видео — случайные клипы с человеком на YouTube.

Алгоритм анализирует, как выглядит человек с разных ракурсов и в непохожих условиях. Затем он сопоставляет лица в целевом видео, находя общие черты.

Для обнаружения и исправления ошибок в дипфейках часто используют генеративно-состязательные нейросети. Это усложняет декодирование таких роликов детекторами подделок.

Хотя создание дипфейков может оказаться сложной задачей, соответствующее программное обеспечение упрощает процесс. Новичкам доступны приложения вроде Zao, DeepFace Lab, FakeApp и Face Swap. Более продвинутые пользователи могут найти релевантное ПО на сервисе GitHub.

Кто создает дипфейки?

Дипфейки могут генерировать исследователи, инженеры машинного обучения, студии визуальных эффектов, режиссеры и энтузиасты. Благодаря популярным приложениям вроде Reface любой желающий со смартфоном способен сделать поддельные фото или видео.

Правительства могут задействовать технологию в рамках стратегий по дискредитации и подрыву экстремистских групп или установлению контактов с целевыми лицами.

Например, в 2022 году южнокорейские разработчики создали дипфейк кандидата в президенты Юн Сок Еля для привлечения молодых избирателей в преддверии выборов. Цифровой аватар похож на реального политика и умеет шутить.

Также дипфейки применяют деятели искусства.

В октябре 2023 года вышел клип на песню «Вовча ягода» украинского исполнителя WELLBOY. Певец Антон Вельбой не участвовал в съемках из-за разрыва сотрудничества с лейблом, поэтому в ролике используются его дипфейк и голос.

Как используют дипфейки?

Многие из созданных дипфейков — порнографические. Согласно отчету стартапа Deeptrace, в 2019 году ролики для взрослых составляли 96% из всех подделок в интернете.

В июне 2023 года ФБР предупредило общественность об опасностях генеративного ИИ и его применении для «создания порнографического контента, секс-вымогательства и преследований».

Дипфейки также используют в преступлениях несексуального характера. Например, в 2023 году злоумышленники подделали голос ребенка, чтобы шантажировать его мать.

В январе 2020 года в ОАЭ мошенники с помощью искусственного интеллекта сымитировали речь руководителя крупной компании и убедили банковского работника перевести $35 млн на их счета.

ИИ-подделки также используются в политике. В 2018 году бельгийская социалистическая партия опубликовала дипфейк, на котором Дональд Трамп призывает страну выйти из Парижского соглашения.

Дипфейки применяются для информационных атак, создания пародий и сатиры.

В 2018 году режиссер Джордан Пил и издание BuzzFeed опубликовали якобы обращение бывшего президента США Барака Обамы, где он назвал Дональда Трампа «засранцем». Ролик создали с помощью приложения FaceApp и графического редактора Adobe After Effects.

Режиссер и журналисты хотели показать, как в будущем могут выглядеть фейковые новости.

В 2022 году после полномасштабного вторжения России на территорию Украины в соцсетях распространили дипфейк президента Владимира Зеленского. В ролике глава государства «призвал народ сдаться».

Однако пользователи быстро определили подделку, а Зеленский записал опровержение.

6 инструментов для создания дипфейков

Ввиду популярности технологии в интернете доступно множество ИИ-инструментов для создания фото и видео дипфейков. Их можно использовать в развлекательных и исследовательских целях.

MyHeritage

Это одно из самых популярных дипфейк-приложений на рынке. Вирусной стала функция Deep Nostalgia, которая позволяет «оживлять» старые фото.

Пользователю достаточно загрузить изображение и нажать кнопку анимации.

Reface

Приложение позволяет заменять одно лицо на другое в видео или GIF.

Пользователю необходимо сделать селфи и выбрать целевой ролик. Через несколько секунд приложение предложит готовую анимацию.

Система не всегда точно сопоставляет людей. Результат зависит от симметрии лица на фото и качества входных данных.

Wombo

Приложение «заставляет» людей на фото петь.

Пользователю нужно сделать селфи и выбрать трек из списка. Система анимирует лицо и синхронизирует его губы с музыкальным произведением.

DeepFakes Web

Сервис позволяет заменить лицо одного человека в видео на другое.

Пользователю необходимо загрузить исходный и целевой ролики. Обработка происходит в облаке и занимает около 30 минут.

При необходимости пользователь может повысить качество созданного дипфейка, повторно применяя обученную модель и повышая качество используемых данных.

Synthesia

Позволяет генерировать высококачественные фейковые видео с помощью искусственного интеллекта. Среди доступных функций: реалистичная смена лиц, синхронизация губ и клонирование голоса.

Однако алгоритмы Synthesia требуют сложного обучения, поэтому сервис предназначен для опытных пользователей.

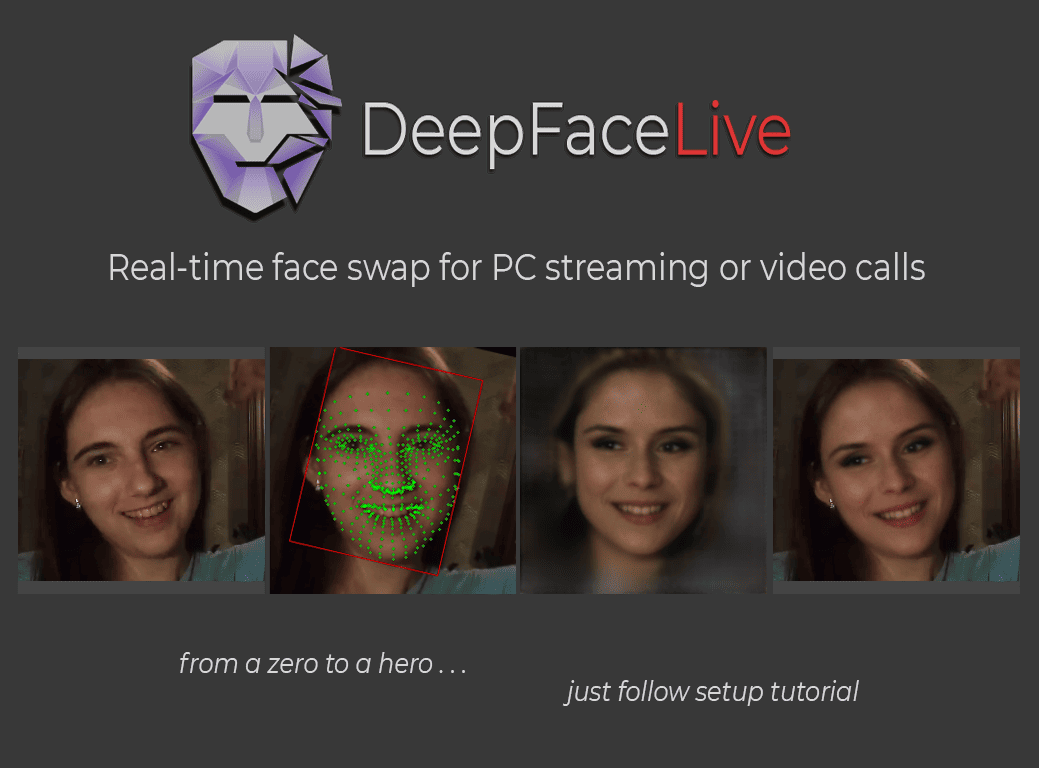

DeepFaceLive

Сервис позволяет подменять лицо пользователя в видео. Он бесплатный и доступен на GitHub.

Алгоритм работает в режиме реального времени. Он умеет накладывать дипфейк в ходе прямых трансляциях или видеоконференций, например, в Zoom.

Для повышения качества работы технологии пользователь может настроить модели вручную. Однако из-за отсутствия подробной документации DeepFaceLive достаточно сложный для новичков.

Программа совместима лишь с видеокартами Nvidia, начиная от модели GeForce GTX 750 и выше.

Как распознать дипфейк?

Часто поддельные фото и видео низкого качества. Однако технология развивается и определить дипфейки становится сложнее.

Но методы обнаружения подделок тоже не стоят на месте. Чтобы выявить дипфейк, пользователю необходимо обратить внимание на определенные детали. Среди них:

- визуальные несоответствия вроде необычных движений тела человека или мимики лица, например, отсутствие моргания. Может наблюдаться непоследовательное освещение или тени, искаженные отражения на радужной оболочке глаз, мерцание и пикселизация по краям транспонированных граней;

- несинхронизированный звук. Часто в дипфейках движение губ не совпадает с речью, что является явным индикатором подделки;

- надежность источников медиаданных;

- контекстуальные подсказки. Необходимо удостовериться в том, способен ли человек говорить и делать то, что демонстрируется в видео или на изображении.

Также можно использовать специальное программное обеспечение для обнаружения дипфейков. Такие системы с помощью различных инструментов и методов анализируют данные на предмет манипуляций.

Однако подобное ПО не всегда надежно на 100%. Результат необходимо перепроверять. Против дипфейков борются крупные технологические корпорации. В апреле 2022 года компании Adobe, Microsoft, Intel и другие объединились в альянс C2PA для обнаружения поддельных фото и видео в интернете.

Вред и польза дипфейков

Помимо дезинформации, преследований, запугиваний и унижений, дипфейки могут подорвать доверие общества, когда люди не хотят или не могут отличить правду от лжи. Это может привести к сомнениям относительно конкретных событий.

Например, в 2018 году министр связи Республики Камерун назвал фейковым видео, где, по мнению правозащитной организации Amnesty International, солдаты казнят мирных жителей.

«Проблема заключается не столько в подделках, сколько в том, что настоящую реальность можно правдоподобно отрицать», — заявила эксперт в области интернет-права в Университете Ньюкасла Лилиан Эдвардс.

Поскольку технология становится более доступной, дипфейки способны создать проблемы для судов, где фальсифицируемые события могут выдаваться за доказательства.

Также технология представляет угрозу для личной безопасности. Дипфейки уже умеют имитировать биометрические данные и обманывать системы распознавания лиц, голоса или походки.

Но, помимо угроз, технология может оказаться полезной.

Дипфейки активно используют в развлекательных целях. Например, стартап Flawless разработал систему, позволяющую синхронизировать движение губ актеров и звуковой дорожки при дублировании фильмов на разные языки.

Пользователи публикуют в соцсетях Instagram и TikTok созданные через Reface отрывки известных кинокартин с замененными лицами персонажей.

В июле 2021 года авторы документального фильма об известном шеф-поваре Энтони Бурдене, который умер в 2018 году, использовали дипфейк для озвучивания его цитат.

Кроме того, технология способна помочь людям вернуть голос, потерянный из-за болезни.

В 2021 году компания Sonantic синтезировала речь актера Вэла Килмера. Он лишился голоса из-за рака гортани.

Также дипфейки используют для создания синтетических наборов данных. Это избавляет разработчиков от необходимости собирать фотографии реальных людей и получать разрешения на их использование.

Что нас ждет в будущем?

Технология продолжит развиваться и основным направлением станет повышение качества подделок. Достижения в областях искусственного интеллекта, машинного обучения и компьютерного зрения, а также улучшение вычислительных мощностей приведут к созданию более убедительного и реалистичного медиаконтента.

Дипфейки способны произвести революцию в индустрии развлечений. Их можно использовать для генерации гиперреалистичных визуальных эффектов, что позволит кинематографистам легко сочетать реальных актеров с виртуальными персонажами.

Возможно, появятся высококачественные цифровые выступления умерших знаменитостей или интересные игровые кроссоверы, созданные фанатами-геймерами.

По мере развития технология станет более доступной для широкой публики. Также увеличится количество инструментов и приложений, позволяющих всем желающим создавать ИИ-подделки.

Дипфейки откроют новые возможности для творчества, но также приведут к росту случаев их неправомерного использования, нарушения конфиденциальности и дезинформации.

Увеличение количества подделок способствует разработке качественных систем обнаружения. Возможно, это также приведет к разработке или адаптации законов и правил для регулирования технологии и устранения потенциального вреда.

Выводы

Дипфейки представляют собой «палку о двух концах» в сфере искусственного интеллекта. Хотя технология предлагает творческие и развлекательные возможности, ее потенциал для неправомерного использования вызывает серьезные опасения.

По мере развития алгоритмов нужно сохранять бдительность и разрабатывать стратегии по смягчению негативных последствий.

Повышая осведомленность людей, инвестируя в технологии обнаружения и реализуя соответствующие правовые и политические меры, общество сможет ориентироваться в сложном ландшафте дипфейков и сохранять доверие, безопасность и целостность цифрового мира.

- Дипфейк — это метод создания медиаданных с помощью алгоритмов глубокого обучения. Технология позволяет заменять лицо человека на другое на существующих фото или видео и копировать его голос.

- ИИ-подделки способны гененировать как исследователи или инженеры, так и энтузиасты.

- Дипфейки можно выявить по визуальным и звуковым несоответствиям или задействуя специальное ПО.

- Помимо секс-вымагательства, преследований, дезинформации, запугиваний и унижений, дипфейки используются в сфере развлечений, синтезирования данных и восстановления голоса.

- Развитие технолгии приведет к созданию более убедительного и реалистичного фальшивого медиаконтента. В свою очередь, это способствует разработке качественных систем обнаружения ИИ-подделок.